Robots TXT Nedir?

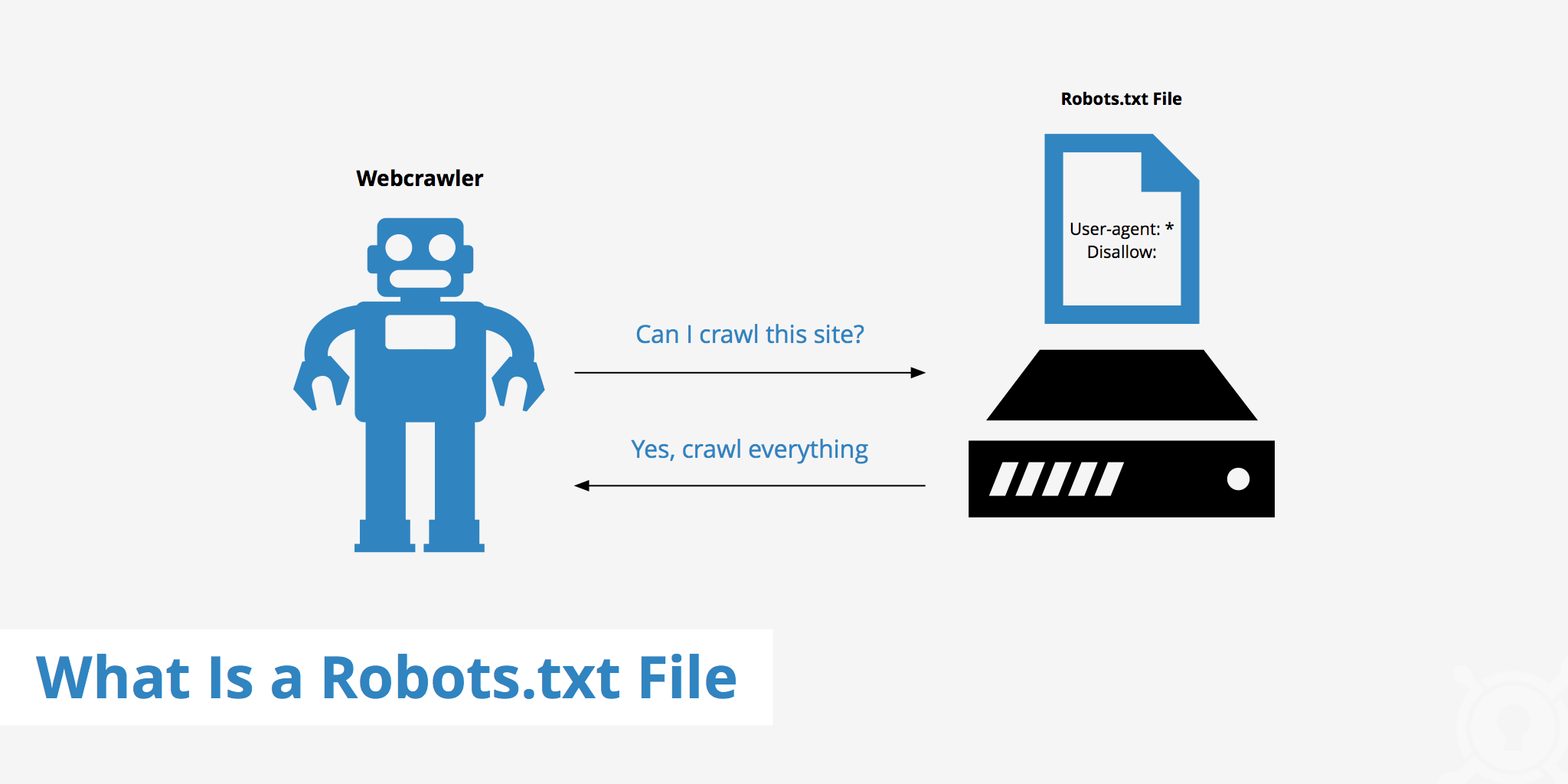

Robots.txt dosyası, web yöneticileri tarafından kullanılan, arama motoru robotlarının (botlarının) bir web sitesini tararken hangi sayfalara erişip hangi sayfalara erişmemesi gerektiğini belirten bir metin dosyasıdır. Bu dosya, web sitesinin kök dizinine yerleştirilir ve genellikle tüm arama motorları tarafından tanınır. Robots.txt dosyası, web sitesinin SEO stratejileri üzerinde önemli bir rol oynar çünkü arama motoru botlarının sitenizi nasıl tarayacağını ve dizine ekleyeceğini belirler.

Robots.txt dosyasının temel amacı, arama motoru botlarının gereksiz sayfaları taramasını ve sunucu kaynaklarını tüketmesini engellemektir. Örneğin, yönetici panelleri, özel veriler içeren sayfalar veya arama motorları için gereksiz olan diğer içerikler gibi belirli sayfaların taranmasını engelleyebilir. Bu şekilde, arama motoru botlarının sitenizin en önemli sayfalarına odaklanmasını sağlayabilirsiniz. Robots.txt dosyası, ayrıca yinelenen içeriklerin taranmasını ve indekslenmesini de engelleyebilir, bu da SEO performansınızı artırabilir.

Robots.txt dosyası oluşturulurken dikkat edilmesi gereken bazı hususlar vardır. Örneğin, yanlış yapılandırılmış bir robots.txt dosyası, sitenizin önemli sayfalarının taranmasını engelleyebilir ve arama motoru sonuçlarında görünürlüğünüzü azaltabilir. Robots.txt dosyasında kullanabileceğiniz çeşitli direktifler vardır. “User-agent” direktifi, belirli bir arama motoru botuna yönelik talimatlar verirken, “Disallow” direktifi, botların erişmesini istemediğiniz sayfaları belirtir. Bu direktifleri doğru ve etkili bir şekilde kullanarak, arama motoru botlarının sitenizi en verimli şekilde taramasını sağlayabilirsiniz.

Robots.txt Dosyasının Önemi ve İşlevi

Robots.txt dosyasının önemi ve işlevi, web sitelerinin arama motoru optimizasyonu (SEO) stratejilerinde kritik bir rol oynamaktadır. Bu basit metin dosyası, web yöneticilerine sitelerinin hangi bölümlerinin arama motoru botları tarafından taranıp taranmayacağını belirleme olanağı sunar. Robots.txt dosyasını kullanarak, yöneticiler arama motorlarının sitelerindeki hangi sayfalara erişeceğini ve hangi sayfaların indekslenmeyeceğini kontrol edebilirler. Bu kontrol, sitenin genel performansını ve arama motorlarındaki görünürlüğünü olumlu yönde etkiler.

Robots.txt dosyasının en önemli işlevlerinden biri, sunucu kaynaklarının verimli kullanılmasını sağlamaktır. Arama motoru botlarının gereksiz sayfaları taraması, sunucu yükünü artırarak sitenin performansını olumsuz etkileyebilir. Özellikle büyük ve kapsamlı sitelerde, belirli sayfaların taranmasını engellemek, sunucu kaynaklarının daha önemli sayfalar için kullanılmasına olanak tanır. Örneğin, yönetici panelleri, özel veriler içeren sayfalar veya yinelenen içerikler gibi sayfaların taranmasını engellemek, arama motorlarının sitenin en önemli ve kullanıcılar için en değerli sayfalarına odaklanmasını sağlar.

Ayrıca, robots.txt dosyası, arama motoru optimizasyonu açısından da büyük bir öneme sahiptir. Yanlış yapılandırılmış bir robots.txt dosyası, sitenizin önemli sayfalarının arama motorları tarafından taranmasını engelleyebilir ve bu durum, arama sonuçlarındaki sıralamanızı olumsuz yönde etkileyebilir. Robots.txt dosyası, SEO stratejisinin ayrılmaz bir parçası olarak doğru ve dikkatli bir şekilde yapılandırılmalıdır. “User-agent” ve “Disallow” gibi direktifler kullanılarak, arama motoru botlarının sitenizi en verimli şekilde taraması sağlanabilir. Bu şekilde, sitenizin arama motoru sonuçlarında daha iyi bir performans sergilemesi ve kullanıcıların aradıkları bilgilere daha hızlı ve kolay bir şekilde ulaşması mümkündür.

Robots.txt Dosyası Oluşturma: İlk Adımlar

Robots.txt dosyası oluşturma, web sitesi yöneticileri için temel bir adımdır ve arama motoru botlarının siteyi nasıl tarayacağını kontrol etmenin en etkili yollarından biridir. Bu dosya, web sitenizin kök dizinine yerleştirilen basit bir metin dosyasıdır ve arama motoru botlarına hangi sayfaların taranıp taranmayacağını belirtir. Robots.txt dosyasını oluşturmanın ilk adımı, öncelikle sitenizin hangi bölümlerinin taranmasını istemediğinizi belirlemektir. Örneğin, yönetici panelleri, özel kullanıcı verileri içeren sayfalar veya yinelenen içerikler gibi sayfaların taranmasını engellemek isteyebilirsiniz.

Robots.txt dosyası oluştururken, belirli direktifler kullanarak botlara talimat vermeniz gerekmektedir. “User-agent” direktifi, belirli bir arama motoru botuna yönelik talimatlar verirken, “Disallow” direktifi, botların erişmesini istemediğiniz sayfaları belirtir. Örneğin, “User-agent: *” tüm botlara yönelik genel bir talimat verirken, “Disallow: /admin” gibi bir ifade, site yöneticisi sayfalarının taranmasını engeller. Bu direktifleri dikkatli ve doğru bir şekilde kullanmak, arama motoru botlarının sitenizi en verimli şekilde taramasını sağlar ve gereksiz sayfa taramalarını önler.

Robots.txt dosyasını oluşturduktan sonra, dosyanın doğru çalışıp çalışmadığını kontrol etmek önemlidir. Bu amaçla, Google Search Console gibi araçlar kullanarak robots.txt dosyanızı test edebilir ve botların talimatlarını doğru bir şekilde takip edip etmediğini görebilirsiniz. Ayrıca, dosyanın güncel kalmasını sağlamak da önemlidir. Web sitenizde yaptığınız değişiklikler ve eklemeler, robots.txt dosyasını da etkileyebilir. Bu nedenle, düzenli olarak robots.txt dosyanızı gözden geçirip güncellemek, sitenizin arama motorları tarafından en iyi şekilde taranmasını ve dizine eklenmesini sağlar. Bu süreç, web sitenizin arama motoru optimizasyonu açısından daha etkili olmasına ve arama sonuçlarında daha iyi sıralamalar elde etmesine yardımcı olur.

Robots.txt Dosyasının Temel Yapısı ve Söz Dizimi

Robots.txt dosyasının temel yapısı ve söz dizimi, web sitelerinin arama motorları tarafından nasıl taranacağını belirlemek için kullanılan kuralları içerir. Bu dosya, genellikle sitenizin kök dizinine yerleştirilir ve arama motoru botları tarafından tarama işlemi başlamadan önce okunur. Robots.txt dosyasının amacı, botların hangi sayfalara erişmesini istediğinizi ve hangi sayfalara erişmemesi gerektiğini belirlemektir. Bu dosya, birkaç basit kural ve direktiften oluşur ve doğru bir şekilde yapılandırıldığında web sitenizin SEO performansını olumlu yönde etkileyebilir.

Robots.txt dosyasının temel yapısı, iki ana direktiften oluşur: “User-agent” ve “Disallow.” “User-agent” direktifi, belirli bir arama motoru botuna yönelik talimatlar verir. Örneğin, “User-agent: *” ifadesi, tüm botlara hitap eden genel bir talimattır. Bunun ardından gelen “Disallow” direktifi, botların erişmesini istemediğiniz belirli sayfaları veya dizinleri belirtir. Örneğin, “Disallow: /admin” ifadesi, site yöneticisi sayfalarının taranmasını engeller. Bu iki direktif birlikte kullanılarak, botların sitenizi nasıl tarayacağını kontrol edebilirsiniz.

Robots.txt dosyasının söz diziminde dikkat edilmesi gereken bir diğer önemli nokta, direktiflerin doğru sırayla ve formatta yazılmasıdır. Her “User-agent” direktifinden sonra, bu bot için geçerli olan “Disallow” ve gerektiğinde “Allow” direktifleri gelir. “Allow” direktifi, “Disallow” tarafından engellenen bir dizin içinde yer alan belirli sayfaların taranmasına izin vermek için kullanılır. Örneğin, “Disallow: /private” ifadesinin ardından gelen “Allow: /private/public.html” ifadesi, botların genel olarak /private dizinini taramasını engellerken, bu dizin içindeki public.html sayfasına erişimine izin verir. Bu esneklik, sitenizin belirli bölümlerini botlardan korurken, diğer bölümlerinin taranmasını sağlayarak SEO performansınızı optimize eder.

Robots.txt Dosyası ile İlgili Anahtar Kavramlar

Robots.txt dosyası, web sitenizin arama motoru botları tarafından nasıl taranacağını kontrol eden basit bir metin dosyasıdır ve içerisinde belirli anahtar kavramlar bulunmaktadır. “User-Agent” direktifi, belirli bir arama motoru botuna yönelik talimatlar verirken, “Disallow” direktifi, botların erişmesini istemediğiniz sayfaları veya dizinleri belirtir. “Allow” direktifi ise, genel olarak engellenmiş bir dizin içinde yer alan belirli sayfaların taranmasına izin verir. Ayrıca, “Sitemap” direktifi, arama motorlarına sitenizin XML site haritasının konumunu bildirerek, botların sitenizi daha etkili bir şekilde taramasını sağlar. Bu anahtar kavramlar, robots.txt dosyasının işlevselliğini ve etkinliğini artırarak, web sitenizin SEO performansını optimize etmeye yardımcı olur.

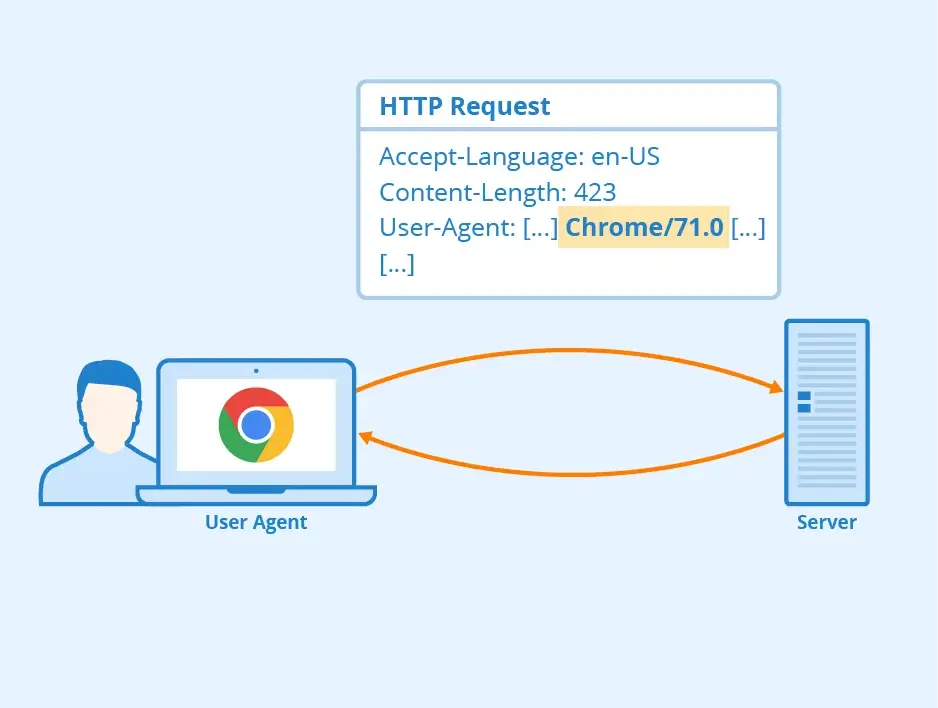

User-Agent

User-Agent, robots.txt dosyasında arama motoru botlarına yönelik özel talimatlar vermek için kullanılan bir direktiftir. Her arama motoru botu, kendine özgü bir kullanıcı ajanı adıyla gelir ve bu ad, robots.txt dosyasında belirli talimatlar vermek için kullanılır. Örneğin, Googlebot, Google’ın arama motoru botunun adıdır ve “User-Agent: Googlebot” ifadesi, sadece Google’ın botuna yönelik talimatlar içerir. Bu sayede, web yöneticileri, farklı arama motoru botları için farklı kurallar tanımlayabilirler. Böylece, sitenizin belirli bölümlerine erişimi sınırlamak veya izin vermek mümkün olur.

User-Agent direktifi, tüm botlara yönelik genel talimatlar vermek için de kullanılabilir. Örneğin, “User-Agent: *” ifadesi, tüm arama motoru botlarını kapsar ve ardından gelen talimatların hepsine uygulanacağını belirtir. Bu, tüm botların belirli sayfalara veya dizinlere erişimini engellemek veya izin vermek istediğinizde kullanışlıdır. Bu esneklik, web sitenizin farklı bölümlerinin kontrolünü sağlarken, aynı zamanda botların sitenizi verimli bir şekilde taramasını sağlar.

Her User-Agent direktifinden sonra, Disallow ve Allow gibi diğer direktifler gelir. Disallow direktifi, botların belirli sayfalara veya dizinlere erişimini engellerken, Allow direktifi, Disallow ile engellenmiş olan bir dizin içindeki belirli sayfalara erişimi sağlar. Bu kombinasyon, web sitenizin hangi bölümlerinin taranacağını hassas bir şekilde kontrol etmenize olanak tanır. Örneğin, “User-Agent: Googlebot” ifadesinin ardından gelen “Disallow: /private” ve “Allow: /private/public.html” direktifleri, Googlebot’un genel olarak private dizinini taramasını engellerken, bu dizin içindeki public.html sayfasına erişmesine izin verir. Bu, arama motorlarının sitenizi en verimli şekilde taramasını ve dizine eklemesini sağlar.

Disallow

Disallow direktifi, robots.txt dosyasının en önemli bileşenlerinden biridir ve arama motoru botlarının belirli sayfalara veya dizinlere erişimini engellemek için kullanılır. Bu direktif, web sitenizin hangi bölümlerinin arama motorları tarafından taranmasını istemediğinizi belirlemenizi sağlar. Örneğin, “Disallow: /private” ifadesi, botların /private dizinine erişimini engeller. Bu, sitenizde yer alan ve arama motorları tarafından taranmasını istemediğiniz hassas veya gereksiz bilgileri korumanın etkili bir yoludur.

Disallow direktifi, SEO stratejileri açısından büyük bir öneme sahiptir. Doğru kullanıldığında, sitenizin arama motorları tarafından daha verimli bir şekilde taranmasını sağlar. Gereksiz sayfaların taranmasını engelleyerek, arama motorlarının sitenizin önemli sayfalarına odaklanmasını sağlayabilirsiniz. Örneğin, yönetici panelleri, kullanıcı hesap sayfaları veya yinelenen içeriklerin bulunduğu sayfalar gibi alanların taranmasını engellemek, sitenizin genel performansını artırabilir. Ayrıca, bu direktif, sunucu kaynaklarının gereksiz yere tüketilmesini önleyerek sitenizin hızını ve kullanıcı deneyimini iyileştirir.

Disallow direktifinin doğru kullanımı, dikkatli bir planlama gerektirir. Yanlış yapılandırılmış bir Disallow direktifi, arama motorlarının sitenizin önemli sayfalarına erişimini engelleyebilir ve bu da arama motoru sıralamalarınızı olumsuz yönde etkileyebilir. Bu nedenle, hangi sayfaların veya dizinlerin engelleneceğini belirlerken dikkatli olunmalıdır. Ayrıca, Disallow direktifi kullanılarak engellenen sayfaların hala kullanıcılar tarafından erişilebilir olduğunu unutmamak önemlidir; sadece arama motoru botları bu sayfalara erişemez. Bu, gizlilik ve güvenlik açısından önemli bir noktadır ve web yöneticilerinin bu direktifi kullanırken dikkatli olmaları gerekir.

Allow

Allow direktifi, robots.txt dosyasının önemli bir bileşeni olup, arama motoru botlarının belirli sayfalara veya dizinlere erişmesine izin vermek için kullanılır. Bu direktif, genellikle Disallow direktifiyle birlikte kullanılır ve daha ince ayarlarla site içeriğinin taranmasını kontrol etmeye yardımcı olur. Örneğin, genel olarak taranmasını engellediğiniz bir dizin içindeki belirli sayfalara erişimi sağlamak istediğinizde Allow direktifini kullanabilirsiniz. “Disallow: /private” ve “Allow: /private/public.html” ifadeleri birlikte kullanıldığında, botlar genel olarak /private dizinine erişemezken, bu dizin içindeki public.html sayfasına erişebilirler.

Allow direktifi, özellikle geniş ve karmaşık sitelerde çok kullanışlıdır. Bazen bir dizini tamamen engellemek isteyebilir ancak bu dizin içinde bazı önemli sayfaların taranmasını sağlamak isteyebilirsiniz. Bu durumda Allow direktifi devreye girer ve arama motorlarının doğru sayfalara erişimini sağlar. Bu sayede, sitenizin önemli içeriklerinin arama motorları tarafından dizine eklenmesini ve bu içeriklerin arama sonuçlarında görünmesini sağlayabilirsiniz. Böylece, sitenizin SEO performansını optimize edebilir ve kullanıcıların aradıkları bilgilere daha kolay ulaşmasını sağlayabilirsiniz.

Allow direktifinin etkili bir şekilde kullanılması, web sitenizin tarama bütçesini daha verimli kullanmanıza yardımcı olur. Arama motoru botlarının tarama bütçesi sınırlı olduğundan, sitenizin gereksiz sayfalar yerine önemli sayfalarını taramalarını sağlamak, sitenizin genel performansını artırır. Bu, hem kullanıcı deneyimini iyileştirir hem de arama motoru sıralamalarınızı olumlu yönde etkiler. Allow direktifi, sitenizin stratejik olarak taranmasını ve doğru içeriklerin arama motorları tarafından indekslenmesini sağlamak için güçlü bir araçtır.

Sitemap

Sitemap, web sitelerinin arama motorları tarafından daha verimli ve kapsamlı bir şekilde taranmasını sağlamak için kullanılan bir dosyadır. Genellikle XML formatında olan bu dosya, sitenizdeki tüm önemli sayfaların bir listesini içerir ve arama motorlarına bu sayfaların nasıl organize edildiğini ve birbirleriyle nasıl ilişkili olduklarını gösterir. Bu, arama motorlarının sitenizin tüm içeriğini keşfetmesini ve dizine eklemesini kolaylaştırır. Robots.txt dosyasına eklenen “Sitemap” direktifi, arama motorlarına sitemap’inizin yerini bildirir ve bu, botların sitemap dosyasına kolayca erişmesini sağlar.

Sitemap kullanımı, özellikle büyük ve karmaşık siteler için hayati önem taşır. İçerik güncellemeleri, yeni sayfaların eklenmesi veya mevcut sayfaların yapısındaki değişiklikler gibi durumlarda arama motorlarının bu değişiklikleri hızla fark etmesini sağlar. Bu dosya, arama motorlarına hangi sayfaların daha önemli olduğunu ve hangi sıklıkla güncellendiğini bildirir, bu da sitenizin arama motorları tarafından daha etkili bir şekilde taranmasını sağlar. Bu sayede, sitenizin içeriği arama sonuçlarında daha hızlı ve doğru bir şekilde yer alır.

Sitemap dosyası, kullanıcı deneyimini iyileştirmek için de önemlidir. Arama motorlarının sitenizdeki içeriği daha iyi anlaması ve organize etmesi, kullanıcıların aradıkları bilgilere daha hızlı ulaşmalarını sağlar. Bu, hem kullanıcı memnuniyetini artırır hem de sitenizin arama motoru sıralamalarını iyileştirir. Sitemap, arama motorlarıyla siteniz arasında bir köprü görevi görerek, web sitenizin tarama ve indeksleme süreçlerini optimize eder. Bu optimizasyon, SEO performansınızı artırarak sitenizin erişilebilirliğini ve görünürlüğünü maksimize eder.

Arama Motoru Optimizasyonu ve Robots.txt

Arama motoru optimizasyonu (SEO), web sitelerinin arama motorları tarafından daha iyi taranması ve indekslenmesi için yapılan stratejik ve teknik düzenlemeleri kapsar. Robots.txt dosyası, SEO’nun önemli bir bileşeni olarak, arama motorlarının sitenizi nasıl tarayacağını kontrol eden kurallar içerir. Bu basit metin dosyası, web sitenizin kök dizinine yerleştirilir ve arama motoru botları tarafından ilk önce okunur. Robots.txt dosyası, belirli sayfaların veya dizinlerin taranmasını engelleyerek, sitenizin arama motorları tarafından daha verimli bir şekilde taranmasını sağlar.

Robots.txt dosyasının doğru yapılandırılması, sitenizin SEO performansını doğrudan etkiler. Örneğin, gereksiz veya hassas sayfaların taranmasını engellemek, arama motorlarının sitenizin önemli sayfalarına odaklanmasına yardımcı olur. Yönetici panelleri, kullanıcı hesap sayfaları veya yinelenen içerikler gibi alanların taranmasını engelleyerek, arama motorlarının tarama bütçesini daha verimli kullanabilirsiniz. Bu da, sitenizin arama motoru sıralamalarında daha üst sıralarda yer almasına ve kullanıcıların aradıkları bilgilere daha hızlı ulaşmasına katkıda bulunur.

Robots.txt dosyasının SEO üzerindeki etkisi sadece sayfaların taranmasını engellemekle sınırlı değildir. Aynı zamanda, arama motoru botlarına sitenizin yapısı ve öncelikleri hakkında bilgi verir. Örneğin, “Sitemap” direktifi ile sitenizin XML site haritasının yerini belirterek, arama motorlarının sitenizin tüm önemli sayfalarını keşfetmesini ve dizine eklemesini kolaylaştırabilirsiniz. Bu, özellikle büyük ve dinamik sitelerde, arama motorlarının içerik değişikliklerini hızlı bir şekilde fark etmesini sağlar. Robots.txt dosyasını etkili bir şekilde kullanmak, web sitenizin SEO stratejilerini destekler ve arama motoru sıralamalarınızı iyileştirir. Bu da, daha fazla organik trafik çekerek sitenizin başarısını artırır.

Robots.txt Dosyasıyla İlgili Yapılan Yaygın Hatalar ve Kaçınılması Gerekenler

- Yanlış yapılandırma ile önemli sayfaların engellenmesi

- Dosyanın kök dizine doğru şekilde yerleştirilmemesi

- Allow ve Disallow direktiflerinin karıştırılması

- Sitemap direktifinin eksik veya yanlış belirtilmesi

- Belirli botlara özel talimatlar vermeyi unutmak

- Tüm botları kapsayan genel talimatları eksik bırakmak

- Dosyanın düzenli olarak güncellenmemesi

- Test edilmeden robots.txt dosyasının uygulanması

Google Search Console Aracılığıyla Robots.txt Kontrolü

Google Search Console, web yöneticilerine sitelerinin performansını izlemek ve optimize etmek için güçlü araçlar sunar. Bu araçlardan biri de robots.txt dosyasının kontrolüdür. Google Search Console’da bulunan Robots.txt Test Aracı, robots.txt dosyanızın doğru yapılandırıldığını ve arama motoru botlarının belirlediğiniz talimatları takip ettiğini doğrulamanızı sağlar. Bu araç, robots.txt dosyanızda yer alan direktiflerin doğru çalışıp çalışmadığını test etmek için kullanılır ve olası hataları tespit etmenize yardımcı olur.

Robots.txt dosyasını kontrol etmek için Google Search Console’a giriş yaptıktan sonra, “Robots.txt Test Aracı” bölümüne giderek mevcut robots.txt dosyanızı görebilir ve test edebilirsiniz. Bu araç, belirli bir URL’nin robots.txt dosyasına göre taranıp taranamayacağını kontrol etmenizi sağlar. Örneğin, belirli bir sayfanın engellenip engellenmediğini öğrenmek için URL’yi girerek “Test” butonuna tıklayabilirsiniz. Araç, URL’nin engellenip engellenmediğini ve hangi direktifin geçerli olduğunu gösterecektir. Bu sayede, olası hataları hızla tespit edebilir ve gerekli düzenlemeleri yapabilirsiniz.

Google Search Console aracılığıyla robots.txt dosyasını düzenli olarak kontrol etmek, sitenizin arama motorları tarafından doğru şekilde tarandığından emin olmanın önemli bir yoludur. Bu araç, robots.txt dosyanızdaki hataları hızlıca bulmanızı ve düzeltmenizi sağlar, böylece arama motoru botlarının sitenizi verimli bir şekilde taramasını ve dizine eklemesini sağlayabilirsiniz. Düzenli kontroller, sitenizin SEO performansını optimize etmenize yardımcı olur ve arama motoru sıralamalarınızı iyileştirir. Bu da sitenizin daha fazla organik trafik çekmesine ve kullanıcıların aradıkları bilgilere daha kolay ulaşmasına katkıda bulunur.